您现在的位置是:首页 > telegeram官网版 > 正文

telegeram官网版

包含transformertokenizer的词条

的tokenizer总结本文提出了一种层次视觉TransformerHiViT从SwinTransformers开始,作者移除了在主阶段跨越token边界的冗余操作,并表明此类。我们使

的tokenizer 总结 本文提出了一种层次视觉 Transformer HiViT从Swin Transformers 开始,作者移除了在主阶段跨越 token 边界的冗余操作,并表明此类。

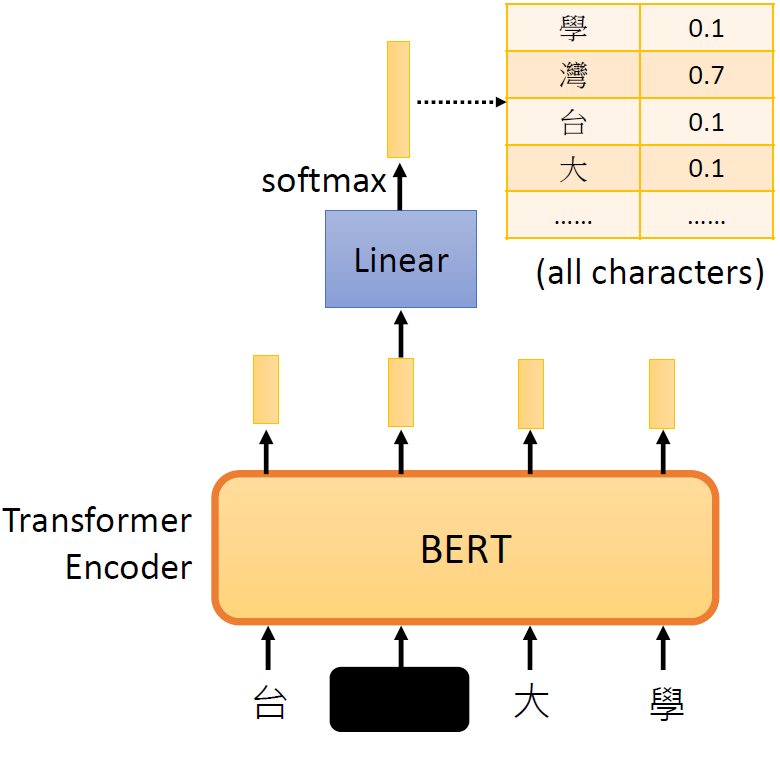

我们使用bert的时候经常会用到huggingface中的tokenizers进行文本分词,其中有很多函数, tokenizertokenize tokenizer,convert_tokens_to_ids。

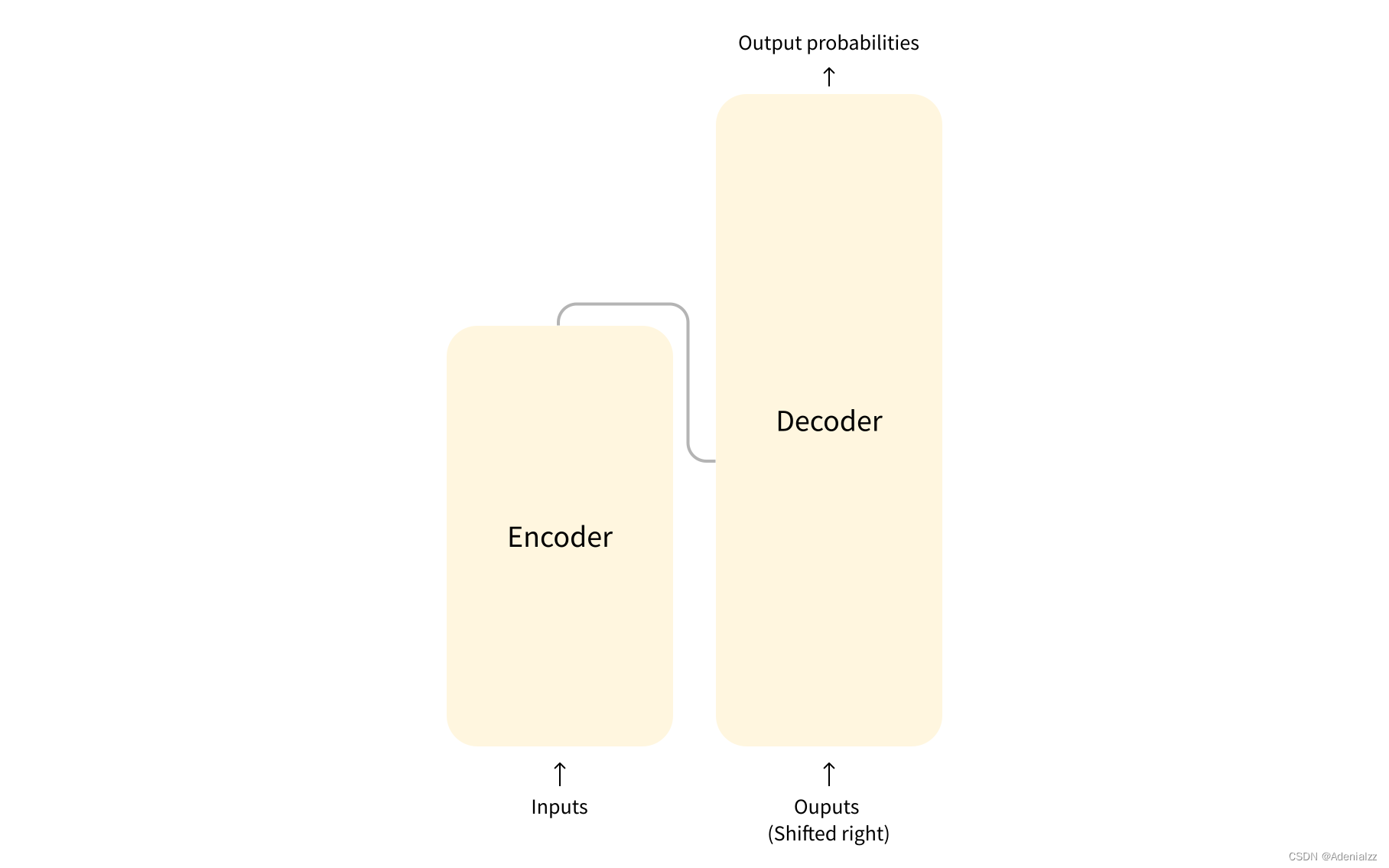

输入文本通过tokenizer进行分词得到对应的token id 支持最大长度为512,然后调用generate函数,将编码的输入文本进行解码,目前。

1加载 tokenizer是进行语言处理的基础,transformer实现分词器的基类是 tokenizer = AutoTokenizerfrom_pretrainedtokenizer_type 后面可以通过 from_。

classPoemGeneratorobjectdef__init__self,model_path,device=#39cpu#39selfmodel=GPT2LMHeadModelfrom_pretrainedmodel_pathselftokenizer=GPT2Tokenizerfrom_pretrainedmodel_pathselfdevice=device。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~